За последние годы мир стал свидетелем удивительного превращения способов, которыми компьютеры создают содержимое. То, что раньше требовало человеческого глаза и руки, теперь может появляться из кода: изображения, тексты, музыка, синтетические данные для исследований. В этой статье я постараюсь объяснить, как работают эти системы, где их уже используют и какие практические и этические вопросы они поднимают.

Что такое генеративные модели и почему это важно

В самом простом виде под этим понятием понимают алгоритмы, умеющие создавать новые образцы данных, похожие на те, на которых они обучились. Это может быть картинка в стиле определённого художника, фрагмент текста в жанре журналистского репортажа или вариации молекулы для лекарства. Главное — способность порождать что-то, а не только классифицировать или предсказывать.

Такие системы меняют подходы к творчеству, проектированию и исследованиям. Когда одна и та же нейросеть может генерировать иллюстрации и краткие описания к ним, это перестаёт быть сюрпризом и становится инструментом. Для бизнеса это экономия времени, для науки — способ синтезировать данные там, где их не хватает.

Краткая экскурсия по архитектурам

Под капотом у таких систем разные архитектуры. Каждая придумана для своего рода задач и несёт собственный набор преимуществ и ограничений. Разобраться в них полезно, чтобы понять, какой инструмент выбирать в конкретном проекте.

Ниже я приведу основные семейства и объясню, чем они отличаются в практическом применении.

Генеративно-состязательные сети (GAN)

Идея простая и в то же время изящная: две сети соревнуются — одна пытается подделать данные, другая учится отличать подделку от оригинала. Соревнование формирует высокое качество генерации, особенно в области изображений. Но у GAN бывают проблемы со стабильностью обучения и с тем, что они иногда «запираются» на ограниченном наборе вариантов.

Я видел, как GAN дают потрясающие портреты с реалистичной фактурой кожи, но при малейшем изменении задания результат может размыться. Для художников и дизайнеров это инструмент с сильной эстетической отдачей, но требующий аккуратной настройки.

Вариационные автокодировщики (VAE)

VAE строят компактное представление данных и умеют плавно переходить между различными примерами. Они хороши, когда важна интерпретируемость латентного пространства и контроль вариаций. Качество изображений обычно уступает GAN, но схема стабильнее и лучше подходит для задач с вероятностной интерпретацией.

Для научных приложений VAE удобны тем, что дают понимание структуры данных и позволяют генерировать множество реалистичных, но разнообразных вариантов. Это особенно полезно при моделировании химических соединений или биологических образцов.

Автопрогрессивные и автокоррелированные модели (autoregressive)

Эти модели создают данные шаг за шагом, предсказывая следующую часть по уже созданной. Такой подход обеспечивает отличное качество в задачах генерации текста и последовательностей. GPT — яркий представитель этого класса, он умеет продолжать текст и формировать связные ответы на запросы.

Шаговый характер генерации делает их ресурсозатратными для длинных последовательностей, но зато результат часто выглядит естественным. Именно поэтому эти модели стали основой для многих языковых приложений и чат-ботов.

Дифузионные модели

Это относительно новый класс, который завоевал популярность в задачах генерации изображений. Идея — постепенно превращать шум в изображение, обучаясь обратному процессу. На практике диффузионные системы создают детализированные и стабильные изображения, причём процесс обучения и генерации более предсказуем, чем у GAN.

Для иллюстраторов и аниматоров диффузионные модели стали ценным инструментом; они дают контролируемую вариативность и хорошую детализацию. Наблюдения из моей практики показывают, что при правильной настройке результат едва ли уступает работам, созданным вручную.

Где применяются эти технологии сегодня

Применение широкое и разнообразное. От развлечений до медицины — инструмент постепенно встраивается в рабочие процессы, а иногда и меняет их. Ниже — конкретные области, где генеративные решения уже принесли реальную пользу.

Я опишу как коммерческие, так и исследовательские кейсы, чтобы показать масштаб возможностей.

Контент и творчество

Иллюстрации, музыка, сценарии и даже стихи становятся возможными за считанные минуты. Авторы используют ИИ, чтобы ускорить прототипирование, получить вдохновение, а иногда и завершить работу. При этом инструмент редко заменяет художника полностью; чаще он выступает партнёром в цикле создания.

В реальных проектах я видел, как дизайн-концепт, созданный с помощью нейросети, служил основой для дальнейшей ручной доработки. Это экономит время и даёт нестандартные варианты, которые трудно было бы придумать сразу.

Промышленный и инженерный дизайн

Генерация вариантов конструкций помогает инженерам быстро оценить множество конфигураций. В архитектуре и промышленном дизайне такие модели создают прототипы, оптимизируют формы под заданные критерии и предлагают неожиданные решения. Для продуктовых команд это способ расширить поле поиска идей.

Иногда генерация даёт конструкции, которые трудно поддаются интуитивному проектированию, но при этом оказываются эффективными. Это меняет роль инженерного мышления — от генератора всех вариантов к ценителю лучших из них.

Медицина и научные исследования

В биоинформатике и фармацевтике модели генерируют молекулы, потенциально полезные как лекарственные кандидаты. В медицинской визуализации они могут синтезировать данные для обучения других моделей в случаях дефицита реальных примеров. Это повышает качество исследований и ускоряет разработку новых решений.

Нужно отметить, что здесь особенно важна валидация: результаты генерации должны проходить строгую проверку экспертами и экспериментальные подтверждения. Без этого риск ложных открытий остаётся высоким.

Как на практике работать с такими системами

При переходе от теории к практике важно понять, как правильно выбирать модель и как её адаптировать к задаче. Речь пойдёт о данных, сложности настройки и базовых хитростях, которые экономят время.

Я расскажу о процессе от подготовки данных до интеграции модели в продукт, основываясь на реальных проектах, где приходилось балансировать качество и затраты.

Подготовка данных

Качество обучающей выборки определяет многое. Чем чище и богаче данные, тем меньше усилий потребуется для получения правдоподобных результатов. Нередко ключ к успеху — корректная аугментация и балансировка классов. Это снижает риск переобучения и улучшает генерацию редких вариантов.

Важно уделить внимание метаданным. В текстовых задачах это тон, жанр и источник данных. В визуальных — разрешение, стиль и аннотации. Без этой информации модель будет «загадочно» генерировать вещи, которые сложно контролировать.

Тонкая настройка и контроль

Fine-tuning позволяет подстроить общую модель под узкую задачу, сохранив её универсальные способности. В некоторых проектах этого шага оказалось достаточно, чтобы получить нужный стиль или терминологию. Но у тонкой настройки есть свои риски: требуется аккуратно выбирать гиперпараметры и следить за смещениями в данных.

Ещё один инструмент контроля — условная генерация, когда модель получает дополнительные сигналы (теги, векторные представления, контекст). Это даёт предсказуемость и позволяет управлять выходом без полного переобучения модели.

Примеры практических приёмов

Вот несколько проверенных приёмов, которые пригодятся в работе: сперва собрать небольшую чистую выборку для оценки качества, затем сделать базовую тонкую настройку и только после этого масштабировать обучение. Так снижается риск потратить ресурсы впустую. Также полезно строить пайплайн для быстрой визуальной проверки результатов.

Когда я работал над проектом генерации маркетинговых изображений, небольшой цикл интерактивной настройки позволил получить нужный стиль за пару итераций. Пользователи ценили скорость итераций даже больше, чем стопроцентное соответствие ожиданиям.

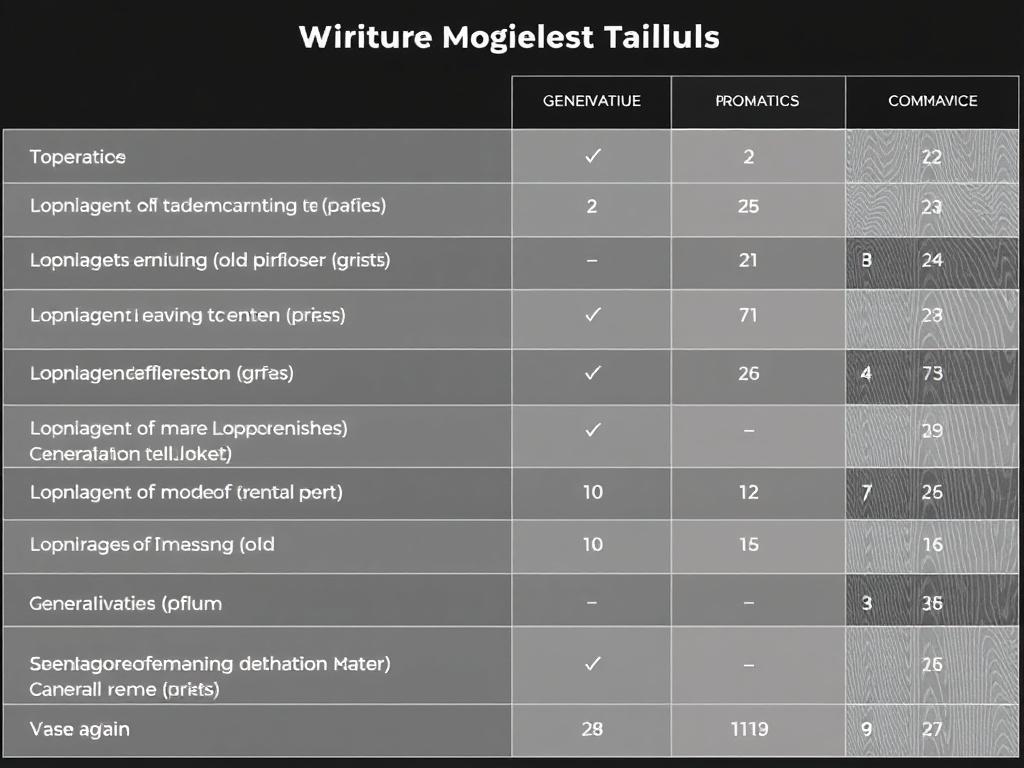

Сравнительная таблица основных подходов

Для наглядности ниже — таблица с сильными и слабым сторонами основных архитектур. Это поможет выбрать направление в зависимости от задачи.

| Метод | Сильные стороны | Ограничения | Примеры |

|---|---|---|---|

| GAN | Высокая реалистичность изображений | Нестабильность обучения, mode collapse | Фотореалистичные портреты |

| VAE | Стабильность, интерпретируемое латентное пространство | Размытие деталей, уступает в реалистичности | Моделирование молекул, вариации форм |

| Autoregressive (GPT) | Отлично для последовательностей и текста | Медленная генерация, ресурсоёмкость | Текстовые ассистенты, автозаполнение |

| Diffusion | Стабильная генерация, хорошая детализация | Требует больше итераций при генерации | Иллюстрации, синтез изображений |

Этические вызовы и риски

Технологии не несут в себе морали, но их применение создаёт последствия. Важно понимать, какие проблемы могут возникнуть и как их минимизировать. Здесь я перечислю ключевые риски и дам рекомендации по их учёту в проектах.

Речь пойдёт о приватности, авторских правах, манипуляции и устойчивости моделей к злоупотреблениям.

Биас и справедливость

Если данные содержат предубеждения, модель их воспроизведёт и усилит. Это особенно опасно в системах принятия решений, где человеческие судьбы зависят от результатов. Заметить и исправить такие искажения сложно, но необходимо.

Работая с образовательными и HR-продуктами, я видел, как небольшое смещение в данных приводит к ощутимым перекосам в выдаче. Решение — тщательная проверка и добавление корректирующих механизмов.

Дезинформация и подделки

Глубокие фейки способны имитировать голоса, лица и стиль текстов, что облегчает распространение ложной информации. Это серьёзная угроза для публичного дискурса. Технологии обнаружения фейков развиваются, но за каждым шагом вперёд следует шаг назад у злоумышленников.

В проектах с потенциально опасным использованием важно встроить механизмы водяных знаков и проверку источников, а также образовательные кампании для пользователей.

Авторские права и оригинальность

Генерация в стиле конкретного художника или писателя поднимает вопросы правомерности. Законодательство в этой области ещё не устоялось, поэтому организации и творцы должны договариваться прямо. Для компаний важно иметь ясные договоры с авторами и прозрачные политики использования выдаваемого контента.

Лично я предпочитаю обсуждать такие вещи заранее, чтобы не доводить до конфликтов после релиза. Это экономит время и сохраняет репутацию.

Технические и практические ограничения

Помимо этических аспектов есть чисто технические проблемы. Понимание их помогает принимать реалистичные решения по внедрению и эксплуатации таких систем. Здесь я перечислю главные ограничения и способы с ними работать.

Это вопросы вычислительных затрат, оценки качества и масштабируемости.

Затраты и инфраструктура

Крупные модели требуют значительных вычислительных ресурсов для обучения и даже для инференса. Это серьёзный барьер для стартапов и небольших команд. Однако облачные сервисы и оптимизированные варианты моделей уменьшают эту проблему. Всё равно приходится выбирать между скоростью, качеством и стоимостью.

В моих проектах экономия достигалась использованием меньших моделей с дообучением на узких данных и мультистадийными пайплайнами. Чаще всего это даёт лучшее соотношение цена/качество, чем попытки обучать «самую большую» модель.

Оценка качества генерации

Оценивать генерацию сложно, особенно для творческих задач. Метрики вроде FID и BLEU дают представление, но не полностью отражают человеческое восприятие. Поэтому практики часто сочетают автоматические метрики с A/B тестами и экспертной оценкой. Это обеспечивает более надёжную картину.

В реальных рабочих процессах важен цикл обратной связи от конечных пользователей. Их ощущения и предпочтения не всегда совпадают с числовыми метриками, но именно они определяют успех продукта.

Практические рекомендации и лучшие практики

Если вы планируете внедрять такие технологии, полезно следовать набору проверенных правил. Здесь я собрал рекомендации, которые сэкономят время и уменьшат риски. Они вытекают из практики в проектах различной масштабности.

Эти пункты помогут спланировать внедрение более предсказуемо и безопасно.

- Чётко формулируйте задачу перед выбором архитектуры: качество изображений или контролируемость латентного пространства?

- Начинайте с небольшой выборки и прототипа; масштабируйте по мере уверенности в результате.

- Интегрируйте механизмы контроля и валидации, включая экспертную оценку и автоматические тесты.

- Учитывайте юридические и этические аспекты ещё на этапе проектирования продукта.

- Документируйте данные и процессы, чтобы можно было отследить происхождение результатов.

Что ждать дальше: тренды и перспективы

Технологии продолжают развиваться динамично. Ожидается дальнейшее объединение подходов, когда сильные стороны разных архитектур комбинируются в гибриды. Это даст более универсальные и управляемые инструменты.

В ближайшие годы важную роль будут играть методы снижения вычислительной стоимости и улучшения интерпретируемости. Появятся стандарты для встраивания гарантий безопасности и прозрачности моделей в продуктах.

Кроме того, стоит ожидать усиления регулирования и развития практик ответственного использования. Это не остановит инновации, но задаст новый вектор развития — более аккуратный и зрелый.

Личный опыт: как я использовал эти инструменты

В нескольких проектах мне приходилось интегрировать модели генерации в рабочие процессы. Один из таких случаев — создание иллюстраций для обучающей платформы. Мы с командой использовали диффузионную модель для быстрой генерации вариантов, затем вручную отбирали и дорабатывали лучшие из них. Это сэкономило нам недели работы иллюстратора на стадии идей и позволило экспериментировать со стилем.

В другом проекте мы использовали тонкую настройку языковой модели, похожей на GPT, чтобы улучшить ответы чат-ассистента. Результат стал более «человечным» по тону, но потребовал серьёзной модерации и фильтрации данных, чтобы избежать внесения нежелательных образцов в базу. Эти уроки научили меня, что технология не решает всё сама по себе — важна грамотная организация процесса.

FAQ — частые вопросы и ответы

Ниже — пять распространённых вопросов с короткими практическими ответами, которые помогут разобраться начинающим.

1. Чем отличаются генеративные модели от обычных классификаторов?

Классификатор присваивает метки существующим объектам, а модели генерации создают новые объекты, похожие на обучающую выборку. Первая задача — различение, вторая — синтез. Это разные подходы и разные метрики оценки.

2. Нужно ли много данных, чтобы получить приличный результат?

Зависит от задачи и архитектуры. Для сложных художественных стилей обычно требуется больше примеров. Однако при помощи тонкой настройки и условной генерации можно добиться хороших результатов и на относительно небольших наборах. Качество данных важнее их количества.

3. Являются ли такие системы опасными для творческих профессий?

Они меняют роль творца, но не обязательно уничтожают профессии. Часто ИИ выступает как инструмент, ускоряющий прототипирование и расширяющий возможности, а человеческий вкус и критическое мышление остаются востребованными. В долгосрочной перспективе важен синтез навыков человека и машины.

4. Как защитить продукты от злоупотреблений, связанных с подделкой содержимого?

Встраивайте водяные знаки, методы детектирования синтетики и процедуры проверки источников. Также полезно внедрять правила доступа и мониторинг использования модели. Часть ответственности лежит на разработчиках и бизнесе, часть — на пользователях и регуляторах.

5. Какие навыки нужны, чтобы начать работать с этими технологиями?

Полезны знания в машинном обучении, программировании и работе с данными. Для практики пригодятся также навыки оценки качества и понимание этических аспектов. Начиная с готовых моделей и библиотек, можно быстро получить первые результаты и постепенно углублять компетенции.

Мы живём в той эпохе, когда инструменты генерации перестают быть экспериментальными и входят в повседневную практику. Понимая принципы их работы и ограничений, можно использовать их с умом и создавать продукты, которые несут пользу, а не только эффект новизны. Это требует внимания к данным, продуманной архитектуры и ответственности за последствия, но наградой станет новая степень гибкости в создании цифрового контента.